Algum dia a IA será completamente imparcial?

Tecnicamente, sim. Um sistema de IA pode ser tão bom quanto a qualidade de seus dados e o design de seus modelos. Por isso é tão importante neutralizar os vieses cognitivos dos algoritmos

Nos últimos anos, a conectividade onipresente e a consumerização de tecnologia levaram ao surgimento do big data. As organizações tentaram aproveitar esses dados para impulsionar a automação e a tomada de decisões com base em dados para melhorar os resultados de negócios.

Mas, todos os dias, erros sistemáticos em nosso processo de pensamento afetam a maneira como vivemos e trabalhamos. E em um mundo onde tudo o que fazemos está mudando rapidamente – desde a maneira como armazenamos informações até a maneira como as analisamos – é preciso lembrar que muitos desses nossos viesses cognitivos acabam encontrando expressão em nossos dados e se infiltrando também em algoritmos de Machine Learning, aumentando a probabilidade de resultados indesejáveis e tendenciosos, uma vez que os dados são a base para todos os algoritmos de aprendizado de máquina e esforços de inteligência artificial. As aplicações dessas tecnologias podem potencialmente amplificar e escalar vários preconceitos humanos.

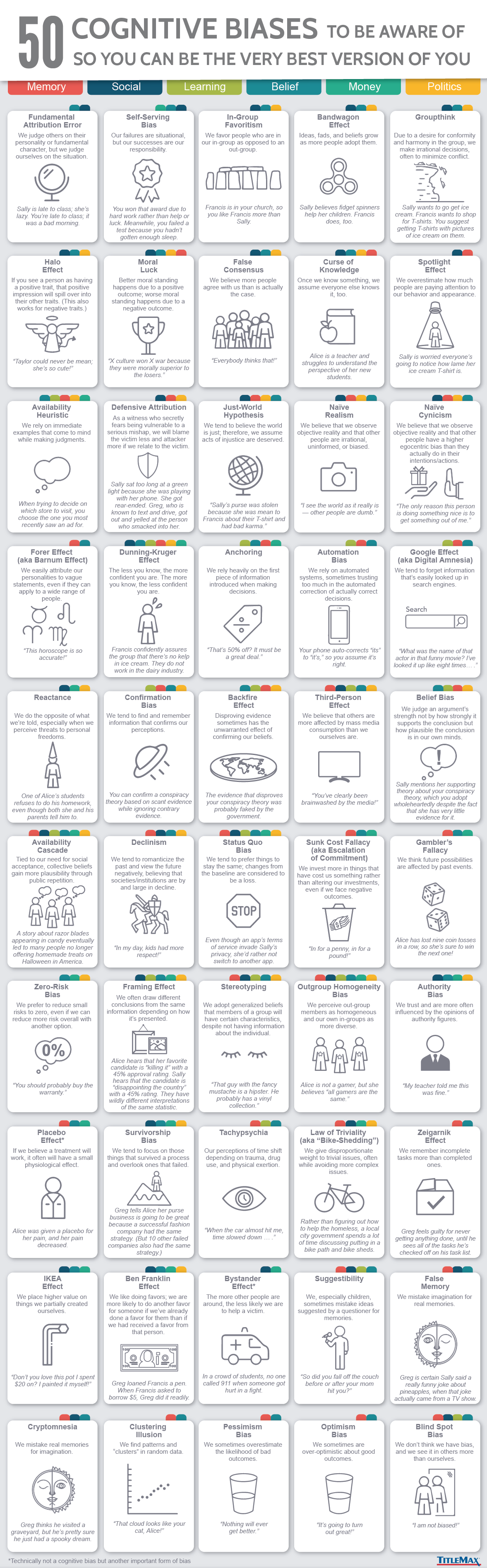

Para evitar que o viés da automação nos leve a cometer seguidos enganos, precisamos trabalhar para minimizar que outros dos 50 vieses cognitivos mais prevalentes hoje em dia, segundo a TitleMax. Conhecê-los é o primeiro passo para implementar e colocar em prática os princípios éticos da IA e garantir a governança adequada para revisão e supervisão contínuas dos modelos e dos dados utilizados, para assegurar a sua qualidade.

Um artigo recente de Michelle Seng Ah Lee e Jatinder Singh, da Universidade de Cambridge, apontou alguns desses vieses que contribuem para distorcem o resultado dos sistemas de IA, quase sempre de maneiras não intencionais. São eles:

- Viés histórico: desalinhamento entre o mundo tal como é e os valores ou objetivos exigidos do modelo de ML;

- Viés de representação: sub-representação ou falha de uma população em generalizar para grupos na população;

- Polarização de medição: escolher e utilizar recursos / rótulos que são proxies barulhentos para quantidades do mundo real;

- Viés de agregação: combinação inadequada de grupos heterogêneos e distintos em um único modelo;

- Viés de avaliação: uso de métricas de desempenho inadequadas ou teste / benchmark externo que não representa toda a população; e

- Viés de implantação: uso ou interpretação inadequada do modelo em um ambiente ao vivo.

Existem inúmeras ferramentas propostas para ajudar os profissionais a avaliar o risco de vieses não intencionais, como avaliações de impacto, modelos de registro e estratégias de mitigação. Empresas como a IBM disponibilizaram ferramentas como o AI Fairness 360 Toolkit, AI FactSheets e IBM Watson OpenScale, projetados para ajudar as empresas a construir uma IA confiável. Mas ainda não há um esforço sistemático para tentar integrar esses métodos em um processo de gerenciamento de risco da organização.

Em teoria, empresas que puderem limpar seu conjunto de dados de treinamento de suposições conscientes e inconscientes sobre raça, gênero ou outros conceitos ideológicos, serão capazes de construir sistemas de IA que tomem decisões baseadas em dados imparciais.

Como corrigir vieses em algoritmos em IA?

Infelizmente, não há uma bala de prata, nem soluções rápidas para remover todos os preconceitos dos sistemas de IA. Mas mas há recomendações que consultores como a Mckinsey vêm aplicando nos últimos anos na tentativa de minimizar o problema.

Na opinião de analistas como Atakan Kantarci, da AI Multiple, significa que para corrigir o preconceito em sistemas de IA as empresas devem:

- Compreender totalmente o algoritmo e os dados para avaliar onde o risco de injustiça é alto;

- Estabelecer uma estratégia de eliminação que contenha um portfólio de ações técnicas, operacionais e organizacionais:

- A estratégia técnica envolve as ferramentas que podem ajudar a identificar fontes potenciais de viés e revelar as características dos dados que afetam a precisão do modelo;

- As estratégias operacionais incluem a melhoria dos processos de coleta de dados usando equipes internas e auditores terceirizados;

- E a estratégia organizacional inclui o estabelecimento de um local de trabalho onde as métricas e os processos sejam apresentados de forma transparente;

- Considerar como os processos orientados por humanos podem ser aprimorados, ao identificar vieses nos dados de treinamento. A construção e avaliação de modelos podem destacar preconceitos que já são percebidos há muito tempo. No processo de construção de modelos de IA, as empresas podem identificar esses vieses e usar esse conhecimento para entender as razões do viés. Por meio de treinamento, desenho de processos e mudanças culturais, as empresas podem melhorar o processo real para reduzir o preconceito;

- Decidir sobre os casos de uso em que a tomada de decisão automatizada deve ser preferida e quando humanos devem estar envolvidos;

- Investir em P&D para minimizar o viés em conjuntos de dados e algoritmos. Eliminar o preconceito é uma estratégia multidisciplinar que consiste em especialistas em ética, cientistas sociais e especialistas que melhor entendem as nuances de cada área de aplicação no processo. Portanto, as empresas devem procurar incluir esses especialistas em seus projetos de IA;

- Considerar que a diversidade na comunidade de IA facilita a identificação de preconceitos. As pessoas que primeiro notam os problemas de preconceito são, em sua maioria, usuários dessa comunidade minoritária específica. Portanto, manter uma equipe diversificada de IA pode ajudá-lo a mitigar vieses indesejados de IA.

Regulação pode ajudar

Já a IBM, em artigo recente assinado por Anjelica Dortch, executiva de Políticas de Tecnologia do IBM Government & Regulatory Affairs e Stacy Hobson, diretora de Tecnologias Responsáveis e Inclusivas, do IBM Research, sugere que os legisladores tomem medidas adicionais em relação ao viés algorítmico, e pede aos governos que implementem cinco prioridades para fortalecer a adoção de testes, avaliações e estratégias de mitigação do preconceito em sistemas de IA:

1. Reforçar o conhecimento e a alfabetização em IA para toda a sociedade. Uma maior compreensão sobre o que é IA, seus benefícios potenciais e como interagir com os sistemas pode acelerar seu crescimento e confiança na tecnologia. Além disso, o desenvolvimento e a implementação de uma agenda nacional de IA podem promover um ecossistema mais inclusivo e diverso, bem como apoiar a erradicação de conceitos errados. Neste sentido, o aumento do investimento em educação para incluir IA nos currículos e o aumento do financiamento para pesquisas podem garantir uma gama mais diversificada de partes interessadas para orientar o planejamento, o desenvolvimento e a implementação de sistemas de IA no futuro. Ministérios e agências de ciência e tecnologia também devem priorizar a construção de parcerias que promovam a equidade em IA.

2. Exigir avaliações e testes para sistemas de IA de alto risco, com foco na proteção dos consumidores e, ao mesmo tempo, possibilitando a inovação. Isso significa exigir evidências e mitigação de vieses – conduzida de forma robusta e transparente – para sistemas de IA, como os usados em tribunais. Esses sistemas também precisam ser monitorados e testados continuamente. Além disso, concentre-se nos requisitos de avaliação de pré-implementação para sistemas de IA de alto risco que apresentam um maior potencial de danos; documentar os processos de avaliação, torná-los auditáveis e mantê-los por um período mínimo de tempo; convocar e conduzir fóruns nacionais e internacionais para acelerar o consenso para uma IA confiável; fornecer recursos e experiências para ajudar todas as organizações a garantir uma IA responsável; aumentar o investimento em pesquisa e desenvolvimento para teste e mitigação de vieses; e apoiar o treinamento acelerado de desenvolvedores em reconhecimento de polarização.

3. Exigir transparência na IA por meio da divulgação. Os desenvolvedores e proprietários devem informar os usuários quando estes interagem com tecnologias de IA com pouco ou nenhum envolvimento humano, bem como ao usar um sistema de IA de alto risco. Além disso, no caso de sistemas de tomada de decisão automatizados, no mínimo, o usuário deve ser informado por que e como uma determinada decisão foi tomada usando IA.

4. Solicitar mecanismos para análise e feedback do consumidor. Os operadores de aplicativos de alto risco devem disponibilizar canais de comunicação (por exemplo, e-mail, número de telefone ou endereço postal) para esclarecer dúvidas, preocupações ou reclamações dos usuários. Os proprietários devem agir com responsabilidade, conduzindo análises contínuas das preocupações dos consumidores e, quando necessário, trabalhar em questões sistêmicas.

5. Estabelecer limitações universais ao uso de IA e adotar práticas de licenciamento responsáveis. Para evitar que os sistemas sejam explorados para usos ilegais, irresponsáveis e prejudiciais, a IBM solicita o estabelecimento de limitações universais ao uso de aplicativos de IA de alto risco para proibir seu uso em vigilância em massa, discriminação racial e violação de direitos humanos e liberdades básicas. Além disso, expanda o desenvolvimento, a educação e a adoção de termos de licença responsáveis para software de código aberto e aplicativos baseados em IA.

De fato, novas leis, marcos regulatórios e diretrizes estão chegando para mitigar vieses nos sistemas de IA. Na opinião da IBM, se desenvolvidas com base nas prioridades acima, essas medidas podem fornecer à indústria e às organizações requisitos claros de teste, avaliação, mitigação e educação para aumentar a confiança do consumidor e a segurança em IA.