Matérias relacionadas

Inteligência Artificial

Inteligência barata, infraestrutura cara

A queda no preço por token amplia demanda e pressiona ROI, enquanto US$ 1,3 trilhão em CapEX redesenha a indústria até 2027.

Inteligência Artificial

SaaS, agentes e a nova economia do software

A automação por IA está deslocando valor da interface para dados, controle e orquestração.

Inteligência Artificial

IA Agêntica depende mais de gente que de código

Agentes prometem escala e eficiência, mas expõem limites organizacionais. O diferencial está na capacidade das empresas de gerir IA como rotina operacional.

Inteligência Artificial

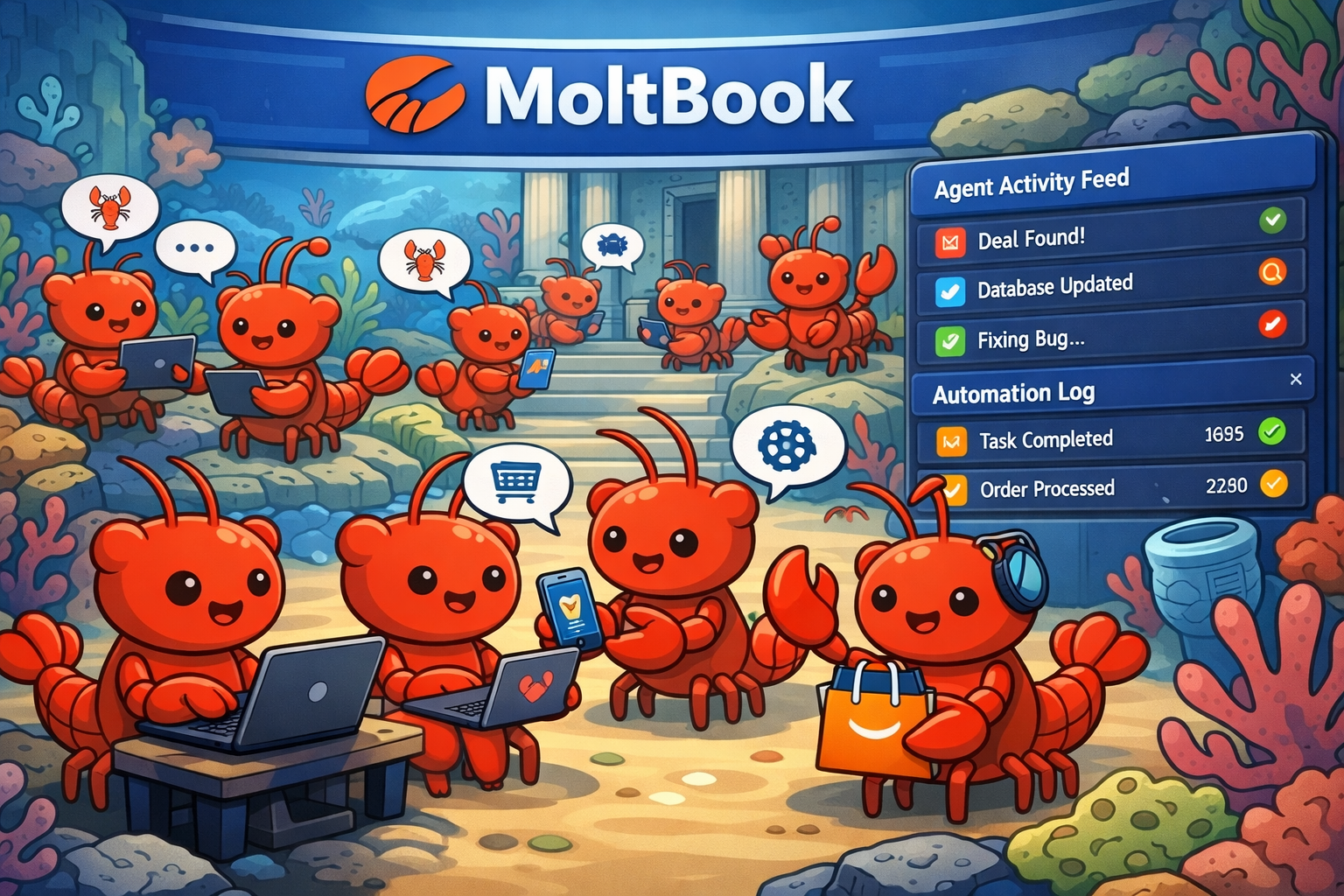

Quem define as regras quando agentes se coordenam?

O que o experimento MoltBook revela sobre o valor econômico, a governança e a liderança em sistemas autônomos.

Inteligência Artificial

Capital cerebral: o limite invisível do crescimento na era da IA

A economia avança com IA, mas esbarra na qualidade do julgamento humano — um fator ainda ausente das métricas e da governança corporativa.

Inteligência Artificial

A IA entrou no orçamento. Falta entrar no modelo de negócio

Pesquisas da PwC e do MIT mostram por que os investimentos em IA avançam mais rápido do que a capacidade das empresas de capturar valor. E por que o problema não é tecnológico, mas estrutural.