Matérias relacionadas

Inovação

A tecnologia acelerou, mas a base científica e humana está encolhend...

Enquanto IA, quântica e biotecnologia avançam, Stanford alerta para a erosão da ciência básica e do capital humano

Inteligência Artificial

SaaS, agentes e a nova economia do software

A automação por IA está deslocando valor da interface para dados, controle e orquestração.

Tendências

Mais cobrança por resultados, menos preparo: a equação de risco das...

Estudos do GPTW, da Gartner e da Harvard Business Review indicam que exigir performance sem recalibrar suporte, cultura e capacitação cobra um preço alto

Tendências

A crise silenciosa do trabalho: por que as empresas estão perdendo fo...

Dados globais indicam que apenas 2 a 3 horas do dia são realmente produtivas, enquanto o “trabalho sobre trabalho” e a fragmentação da agenda corroem a eficiência

Inteligência Artificial

IA Agêntica depende mais de gente que de código

Agentes prometem escala e eficiência, mas expõem limites organizacionais. O diferencial está na capacidade das empresas de gerir IA como rotina operacional.

Inteligência Artificial

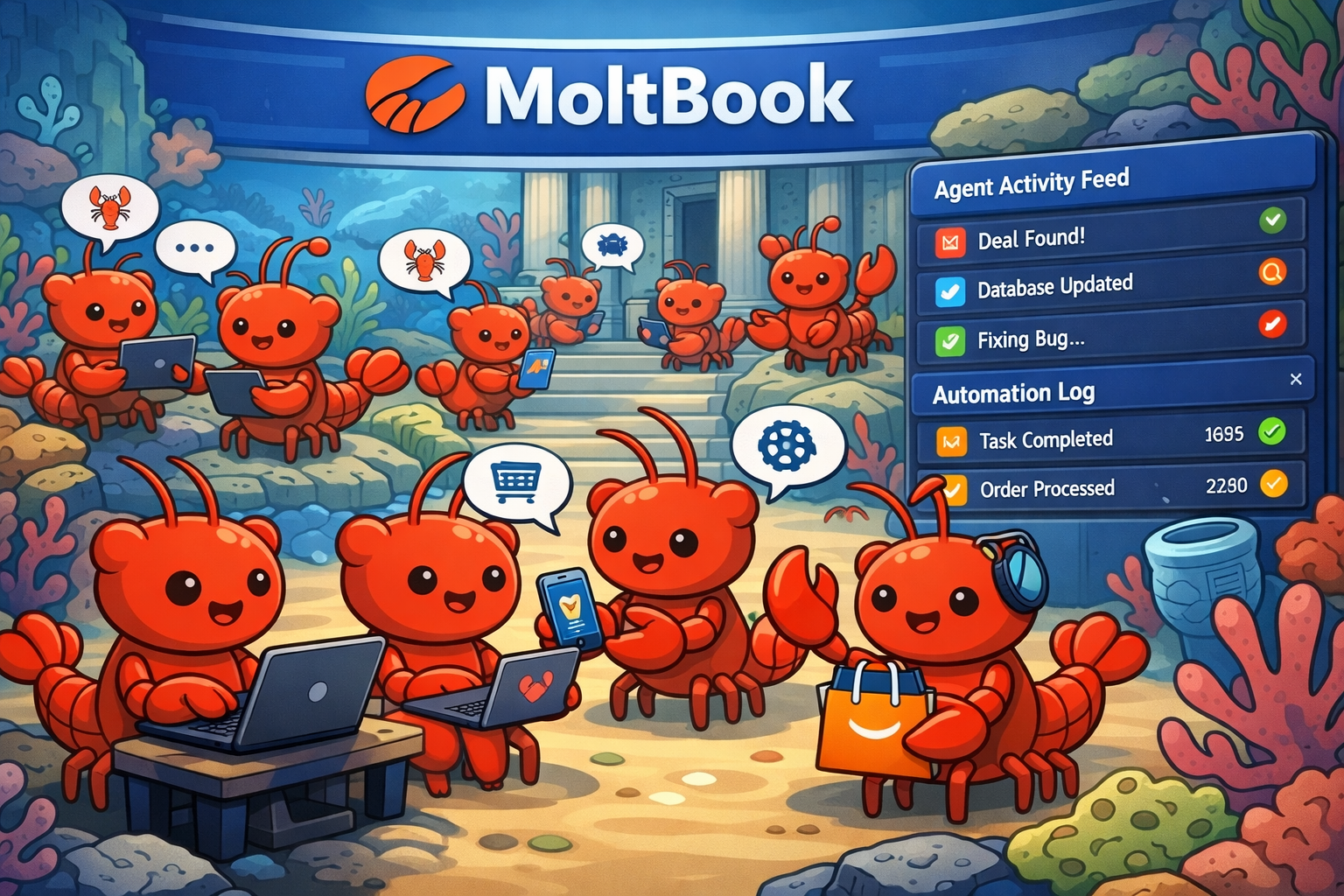

Quem define as regras quando agentes se coordenam?

O que o experimento MoltBook revela sobre o valor econômico, a governança e a liderança em sistemas autônomos.