AI Index 2025: a corrida não é por capacidade, e sim por controle

Relatório anual de Stanford mostra que a inteligência artificial ficou mais barata, rápida e onipresente — e que o verdadeiro poder está agora nas mãos de quem implementa

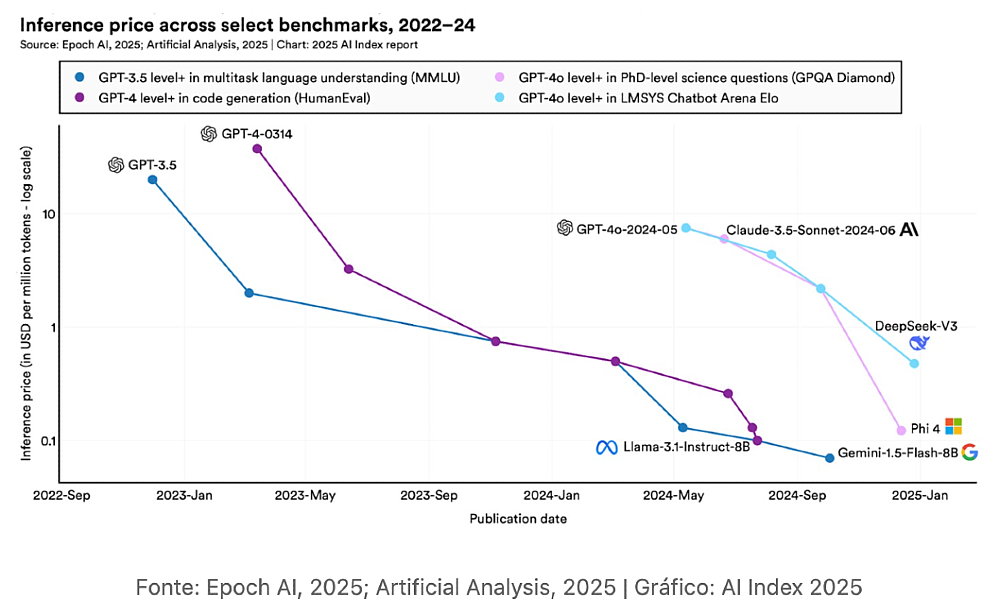

O uso de IA de nível GPT-3.5 ficou 280 vezes mais barato em apenas 18 meses. Modelos pequenos estão vencendo – Phi-3-mini (parâmetros 3.8B) agora corresponde aos modelos 540B de 2022. O hardware ficou 40% mais eficiente em um ano (o uso de energia, nem tanto). O desempenho dos modelos disparou em benchmarks rígidos como o SWE-bench (de 4,4% para 71,7%). A adoção aumentou (78% das empresas agora, contra 55% em 2023). E a maioria relata ganhos de custo/receita de cerca de 10%, especialmente em Marketing, Operações e Cadeia de Suprimentos.

Em resumo, as mais de 450 páginas do relatório “AI Index 2025”, da HAI, de Stanford, mostra que a IA está se tornando invisível, incorporada em tudo. Que o poder está mudando para aqueles que a implementam, não apenas para aqueles que a inventam. E que a corrida silenciosa agora é por controle, não por capacidade.

Cada capítulo (são oito, no total) tem conteúdo para horas de discussão. O que o torna leitura obrigatória para todos que desejam se manter atualizados e se aprofundar nos principais temas da evolução da IA. Em vez de tentar espremer tudo em um post, vamos nos aprofundar no que mais importa para o ambiente de negócios.

• Investimento. Foram US$ 252 bilhões em 2024. EUA lideraram com US$ 109 bilhões – 12 vezes mais que a China.

• Geopolítica. Os EUA continuam sendo os líderes nos principais modelos de IA, mas a China está se recuperando rapidamente, dominando a pesquisa e as patentes. Novos players da América Latina, Sudeste Asiático e Oriente Médio estão deixando sua marca com modelos competitivos.

• Formação. O ensino de IA e Ciência da Computação está se expandindo, mas ainda há lacunas no acesso e na preparação. Dois terços dos países agora oferecem ou planejam oferecer educação em Ciência da Computação do Ensino Fundamental ao Médio – o dobro de 2019 – com a África e a América Latina fazendo o maior progresso.

• Brasil. Tem uma das maiores taxas relativas de crescimento anual na contratação de talentos em IA. E registra um crescimento percentual expressivo (217%) na concentração de talentos. É reconhecido como um dos principais países na formação de graduados em Tecnologias da Informação e Comunicação (TIC).

• Regulamentação. Em 2024, as agências federais dos EUA introduziram 59 regulamentações relacionadas à IA – mais que o dobro do número em 2023 – e emitidas por duas vezes mais agências. Globalmente, as menções legislativas à IA aumentaram 21,3% em 75 países.

• Desempenho. A escala dos modelos continua a crescer rapidamente – a computação de treinamento dobra a cada cinco meses, os conjuntos de dados a cada oito e o uso de energia anualmente. Mas as lacunas de desempenho estão diminuindo: a diferença de pontuação entre os modelos mais bem classificados e os 10º colocados caiu de 11,9% para 5,4% em um ano, e os dois primeiros agora estão separados por apenas 0,7%. A fronteira está cada vez mais competitiva – e cada vez mais lotada.

• Aberto X Fechado. Os modelos de código fechado ainda lideram em desempenho, mas os modelos abertos estão ganhando terreno e aumentando a acessibilidade. A diferença de desempenho caiu de 8% para apenas 1,7% em alguns benchmarks, em um ano.

• Custo de treinamento. O AI Index não tem dados precisos, porque muitas das principais empresas de IA pararam de divulgar informações sobre seus treinamentos. Mas os pesquisadores fizeram uma parceria com a Epoch AI para estimar os custos de pelo menos alguns modelos com base nos detalhes obtidos sobre a duração do treinamento, o tipo e a quantidade de hardware, entre outros. O modelo mais caro para o qual eles conseguiram estimar os custos foi o Gemini 1.0 Ultra do Google, com um custo impressionante de cerca de US$ 192 milhões. O aumento geral dos custos de treinamento coincidiu com outras descobertas do relatório: os modelos também continuam a aumentar o número de parâmetros, o tempo de treinamento e a quantidade de dados de treinamento.

• Custo de uso. Os custos de hardware estão diminuindo, o desempenho do hardware está aumentando e a eficiência energética está aumentando. Isso significa que os custos de inferência, ou a despesa de consultar um modelo treinado, estão caindo drasticamente. Dependendo da tarefa, os preços de inferência LLM caíram de 9 a 900 vezes por ano. O custo de consultar um modelo de IA que pontua o equivalente a GPT-3.5 (64,8% de precisão) no MMLU caiu de US$ 20 por milhão de tokens em novembro de 2022 para apenas US$ 0,07 por milhão de tokens em outubro de 2024 (Gemini-1.5-Flash-8B) – uma redução de mais de 280 vezes em aproximadamente 18 meses.

• Raciocínio. Aquele mais complexo continua sendo um desafio. Sistemas baseados em aprendizagem que geram e verificam hipóteses usando métodos simbólicos têm um bom desempenho – embora não sobre-humano – em tarefas como problemas da Olimpíada Internacional de Matemática. Os LLMs, no entanto, ainda ficam para trás em benchmarks de raciocínio complexos como MMMU e lutam para resolver de forma confiável tarefas pesadas em lógica, como Aritmética e Planejamento, mesmo quando soluções corretas são comprováveis. Isso limita seu uso em cenários de alto risco e precisão crítica.

• Agentes. Cada dia mais úteis. Em cenários com horizonte temporal curto (duas horas), os principais sistemas de IA pontuam quatro vezes mais que os especialistas humanos, mas quando recebem mais tempo para realizar uma tarefa, os humanos têm um desempenho melhor do que a IA – superando-a em 2 para 1, com 32 horas. Ainda assim, os agentes de IA já se equiparam à perícia humana em tarefas selecionadas, como escrever tipos específicos de código, ao mesmo tempo em que entregam resultados.

• IA Responsável (RAI). Evolui de forma desigual. Os incidentes relacionados à IA estão aumentando acentuadamente, mas as avaliações de RAI padronizadas continuam raras entre os principais desenvolvedores de modelos industriais. Enquanto as empresas ficam para trás em ação, os reguladores globais estão se esforçando. Muitos países agora têm institutos de segurança de IA ativos (ou órgãos equivalentes), incluindo os EUA, o Reino Unido, o Japão e a União Europeia (UE). Em 2024 surgiram novas estruturas da OCDE, UE, ONU e União Africana, enfatizando transparência e confiança.

• Impacto ambiental. Embora a eficiência energética seja uma tendência positiva, o consumo geral de energia está aumentando, o que significa que os data centers no centro do boom da IA ainda têm uma enorme pegada de carbono. O AI Index estimou as emissões de carbono de modelos de IA selecionados com base em fatores como hardware de treinamento, provedor de nuvem e localização, e descobriu que as emissões de carbono do treinamento de modelos de IA de ponta aumentaram constantemente ao longo do tempo, sendo o DeepSeek o mais discrepante, e a família Llama, da Meta, a grande vilã.

Nestor Maslej, gerente de pesquisa do HAI e um dos coordenadores do AI Index, comentou algumas das conclusões da edição deste ano.

Na sua opinião, os principais desenvolvimentos em modelos de IA em 2024 foram os modelos de raciocínio aprimorado e com capacidades multimodais. “Mas particularmente notável é o surgimento de modelos menores que oferecem desempenho impressionante”, diz ele. “Vimos uma redução drástica na contagem de parâmetros, mantendo o desempenho — do PaLM com 540 bilhões de parâmetros em maio de 2022 para o Phi-3 Mini com apenas 4 bilhões de parâmetros em maio de 2024, enquanto ainda alcançava acima de 60% no benchmark MMLU. À medida que essas capacidades técnicas amadurecem, o campo está mudando de buscar puramente o avanço tecnológico para se concentrar na integração prática dessas ferramentas poderosas em fluxos de trabalho de negócios.”

A tendência clara é que os modelos estão ficando menores, mas mantendo altos níveis de desempenho, o que entusiasma muitas empresas devido às potenciais economias de custos e ganhos de eficiência. Mas um grande desafio segue sendo a criação de interfaces e fluxos de trabalho que tornem a IA realmente útil para empresas, além dos chatbots.

Outras duas tendências significativas, na sua opinião? “Os modelos de peso aberto estão muito mais fortes do que há um ano. De acordo com o Chatbot Arena, a lacuna entre o melhor modelo de peso fechado e o melhor modelo de peso aberto diminuiu de cerca de 8 pontos percentuais em janeiro de 2024 para apenas 2% em fevereiro de 2025. E o ecossistema está se tornando mais transparente. Embora, de acordo com o Stanford’s Foundation Model Transparency Index, ainda haja espaço significativo para melhorias, com muitos provedores não divulgando totalmente os detalhes sobre o desenvolvimento de seus modelos e métodos de treinamento.

Maslej ressalta que o cenário competitivo se estreitou consideravelmente. Há um ano, modelos proprietários da OpenAI, Anthropic e Google tinham uma clara vantagem de desempenho. Agora, novos modelos como Llama 3, DeepSeek e Qwen ( do Alibaba) fecharam essa lacuna. “Temos um ecossistema altamente competitivo com 4-5 desenvolvedores, todos lançando modelos capazes que pontuam de forma semelhante em benchmarks. Essa mudança transforma modelos abertos em uma opção muito mais viável e competitiva para empresas que buscam construir aplicativos de IA”, diz ele.

Os benchmarks que eram considerados desafiadores em 2023 tiveram um progresso notável, com aumentos de desempenho de 20-60 pontos percentuais em apenas um ano. “À medida que os modelos saturam os benchmarks existentes, os pesquisadores desenvolvem continuamente novos desafios”, explica Maslej. Por exemplo, a ARC lançou recentemente um novo benchmark que ainda desafia os sistemas, e a Epoch AI lançou o “Frontier Math”, um benchmark matemático complexo com o qual até mesmo sistemas de alta qualidade têm dificuldade. “Em uma reviravolta humorística, os pesquisadores até lançaram um benchmark apelidado de ‘Último Exame da Humanidade’ – sugerindo de forma brincalhona que pode ser o teste acadêmico final necessário para avaliar os sistemas de IA”, comenta o pesquisador. Este ciclo contínuo, na sua opinião, ilustra o ritmo rápido do avanço da IA e os padrões em evolução para avaliação de desempenho.

Importante: há uma crescente desconexão entre benchmarks acadêmicos e aplicações do mundo real. Os melhores sistemas de IA agora superam os humanos em muitos testes acadêmicos, mas tarefas do mundo real continuam desafiadoras para capturar em benchmarks organizados. Para as empresas, saber que um modelo pontua 97% em questões de matemática do oitavo ano é menos relevante do que entender como ele se sai em tarefas comerciais específicas. Os profissionais devem avaliar os modelos com base em suas necessidades e restrições comerciais específicas, considerando fatores como precisão, velocidade, latência e custo — em vez de depender apenas de tabelas de classificação de benchmark.

Sobre a viabilidade econômica de uso de modelos de raciocínio avançado, na opinião de Maslej as empresas precisam conduzir modelagem financeira para determinar se o valor derivado justifica o custo. Por exemplo, um assistente de codificação pode consumir computação significativa para resolver tickets do JIRA, mas a questão-chave é se a saída é tão boa e mais barata do que a de um desenvolvedor júnior. “Ferramentas de análise de IA podem auxiliar analistas, mas podem não substituir completamente seu julgamento”, diz ele. A consideração crítica é se os modelos economizam tempo suficiente ou criam valor suficiente para justificar seu custo. O “melhor” modelo para uma empresa não é necessariamente o de melhor desempenho geral, mas aquele que atende com mais eficácia a requisitos operacionais específicos.

A questão-chave agora não é sobre o avanço da tecnologia, mas sobre como as empresas integrarão efetivamente essas ferramentas para gerar valor. O desafio é encontrar fluxos de trabalho específicos onde a IA pode fornecer benefícios claros que justifiquem a implementação.

• Como faz todos os anos, o IEEE Spectrum também selecionou os pontos do AI Index que, na opinião dos seus técnicos, contam a verdadeira história da IA no momento. Vale conferir.